«La inteligencia artificial no es neutral, responde a intereses»

La Comisión Europea reúne a 52 expertos independientes para debatir unas directrices éticas sobre esta tecnología

I.A.

Martes, 19 de noviembre 2019, 11:10

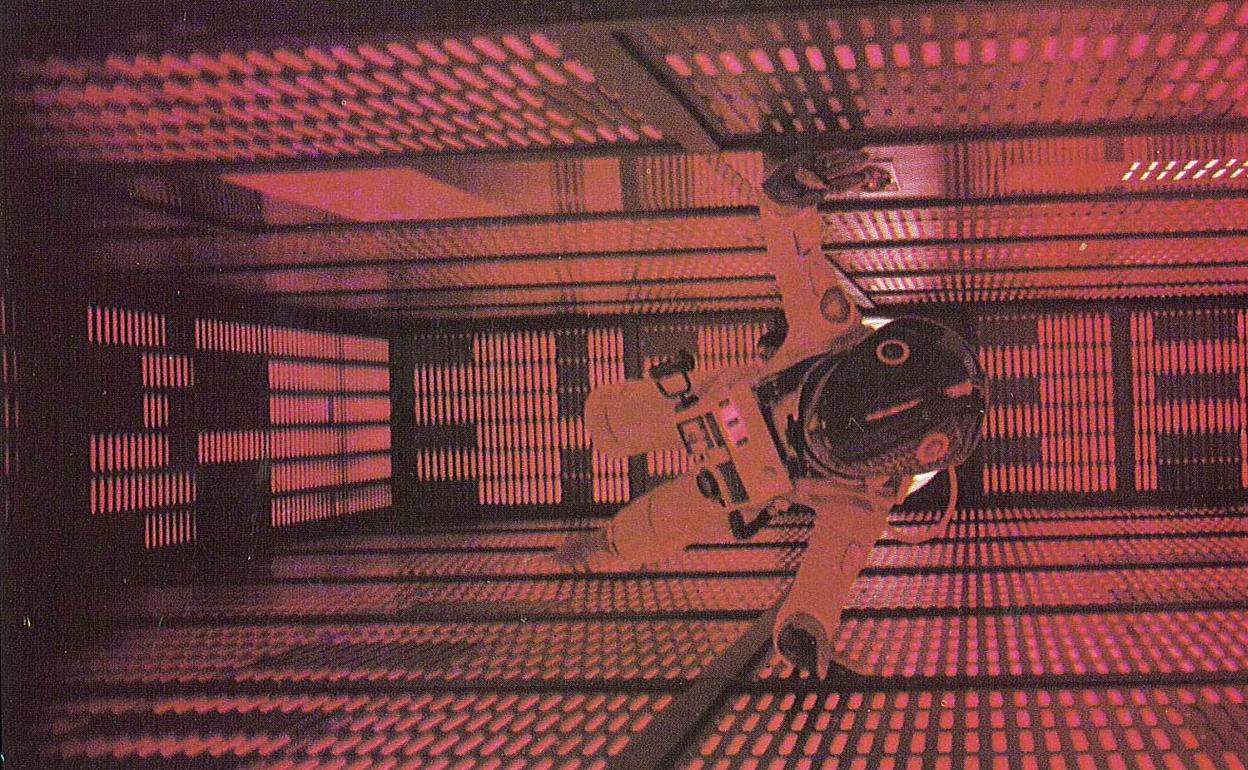

Sonaba a película dirigida por Stanley Kubrick y ha terminado por ser una palabra de moda y sobre todo una realidad tangible que nos acompaña a donde quiera que vamos. Ha transformado nuestras rutinas y se aplica en campos tan diversos como la sanidad, la ciencia, los transportes o las finanzas. La inteligencia artificial (IA) alcanzará los 52.700 millones de euros, 9 veces más de lo que se invierte hoy en este sector, en 2025, según concluye la empresa de robótica colaborativa y estructuras inteligentes Airtificial.

«Aunque puede traer beneficios a los individuos y la sociedad, la IA también puede tener un impacto negativo». Así explicaba a finales del año pasado la Comisión Europea la llegada de la inteligencia artificial a la vida de los europeos. El aumento progresivo del uso de esta tecnología ha llevado a la Comisión Europea a reunir a 52 expertos independientes para debatir unas directrices éticas que habrá que seguir en el desarrollo y el uso de la inteligencia artificial.

«Todo descubrimiento, nueva creación o nueva capacidad que desarrollamos para generar un nuevo poder o una nueva posibilidad de hacer las cosas conllevan la pregunta de quién hará uso de ellos y qué dirección les queremos dar, porque todo puede utilizarse para generar bienestar o para destruir», explica Miquel Seguró Mendlewicz, profesor colaborador de los Estudios de Artes y Humanidades de la UOC.

Por ello se considera necesaria una reflexión ética sobre la inteligencia que se plantee preguntas como «qué es la inteligencia, qué es artificial, quién hace este artificio, por qué, para qué, si el objetivo es generar más justicia social y más bienestar o generar una competencia neocapitalista para ver quién se desarrolla mejor por medio de las capacidades que esta inteligencia pueda ofrecer, si es para el bien público y, por tanto, quedará en manos del estado o no… La ética de la inteligencia artificial se queda, más que en la respuesta, en la pregunta. Desde la filosofía tenemos que ensanchar el espacio de la pregunta», señala el profesor experto en filosofía política y ética, quien cree que los principales retos para la ética de la inteligencia artificial pueden resumirse en cuatro:

-

La inteligencia artificial no es neutral, responde a unos intereses y a unos usos, y son estos los que hay que definir para concretar en qué dirección van.

-

Detrás de cualquier tipo de artificio que se genere existe la responsabilidad humana, y, por tanto, también detrás de la idea de inteligencia artificial, esa responsabilidad no es ineludible.

-

La idea de inteligencia, por un poso positivista y neopositivista, se ha reducido coloquialmente a la capacidad de cálculo, de racionalizar, de llevar a cabo operaciones de precisión, y se ha dejado fuera de esta noción otras posibilidades que tienen que ver más con las humanidades, el arte, etc. Pero inteligencias hay muchas: habría que definir qué tipo de inteligencias queremos generar.

-

Es necesario concretar el uso político que se va a hacer de esta inteligencia y quién va a vigilar que se use de manera equitativa.

La atracción que el desarrollo de la inteligencia artificial ejerce en la sociedad ha llevado a los expertos a preguntarse qué es lo que nos resulta tan fascinante de ella. Y la respuesta parece apuntar al anhelo de control. Como explica Miquel Seguró, existe la ilusión de que por medio de la inteligencia artificial «tendremos un mayor control de nuestras vidas y de los problemas que nuestras vidas incluyen. Pero eso es solo una cara de la experiencia, porque hay abrazos, sonrisas, silencios… que no hay manera de programar ni de predecir, ya que dependen del contexto y de unas habilidades que no son meramente cuantitativas, sino que exigen un desarrollo personal, una audacia personal y asumir la capacidad de errar», señala.

Discriminación de los algoritmos

De hecho, el control total no parece posible. La inteligencia artificial usa algoritmos para extraer conclusiones y tomar decisiones. Y todo ese proceso usa datos que, en ocasiones, pueden ser discriminatorios. Fue lo ocurrido con el algoritmo Compas, creado para ayudar a los jueces de Estados Unidos a decidir sobre la libertad provisional. Tras las primeras pruebas se concluyó que se trataba de un algoritmo racista porque usaba datos de departamentos policiales donde la mayoría de los detenidos eran negros, por lo que el algoritmo estableció que el riesgo de ser criminal era mayor entre esas personas.

Un colectivo con muchas probabilidades de ser discriminado en los programas de inteligencia artificial es el de los mayores, que corren el riesgo de ser invisibilizados. Como explican las investigadoras de la UOC Andrea Rosales y Mireia Fernández Ardèvol, expertas en personas mayores y TIC, los sistemas de inteligencia artificial utilizados para recoger y analizar datos se olvidan con frecuencia de este colectivo. «Cuando se investigan los usos de los espacios públicos de una ciudad, se analizan los datos de los móviles que tienen el wifi encendido: desde el tiempo que las personas emplean en cruzar una calle por un semáforo hasta el tiempo que necesitan para subir las escaleras del metro. Pero en el análisis de estos estudios no se tienen en cuenta minorías que o bien no tienen wifi en el móvil o bien, si lo tienen, lo llevan siempre apagado», señalan como ejemplo de las posibles discriminaciones que pueden cometerse en el uso de la inteligencia artificial.